Ollama Công cụ mã nguồn mở chạy LLM cục bộ

Ollama là một công cụ mã nguồn mở miễn phí giúp đơn giản hóa việc chạy các mô hình ngôn ngữ lớn (LLM) trực tiếp trên máy cục bộ. Công cụ này cung cấp một API đơn giản và thư viện mô hình dựng sẵn, hỗ trợ cả nhà phát triển lẫn những người đam mê AI. Với khả năng chạy ngoại tuyến và bảo mật dữ liệu, Ollama đang trở thành một trong những lựa chọn phổ biến nhất để triển khai LLM tại chỗ mà không cần phụ thuộc vào đám mây.

Ollama là gì?

Ollama là một công cụ mã nguồn mở hỗ trợ chạy chương trình, chủ yếu được viết bằng Golang (89%) và được thiết kế để chạy các mô hình ngôn ngữ mở ngay trên máy cục bộ hoặc máy chủ. Phần mềm này không chỉ vận hành các mô hình mà còn cung cấp lớp API để tích hợp vào ứng dụng và dịch vụ khác.

Điểm mạnh của Ollama là sự đơn giản và thân thiện với người dùng. Công cụ này đóng gói các mô hình bằng file riêng (.modelfile), giúp dễ dàng cài đặt, quản lý và tùy chỉnh. Người dùng có thể tải về, quản lý và chạy nhiều loại LLM như Llama 3.2, Mistral, Code Llama, LLaVA, Phi-3,… mà không cần cấu hình phức tạp.

Khác với các dịch vụ AI dựa trên đám mây, Ollama hoạt động hoàn toàn ngoại tuyến. Điều này đảm bảo dữ liệu của bạn luôn được lưu trữ cục bộ, tránh rủi ro bị thu thập hoặc sử dụng cho mục đích huấn luyện mô hình của bên thứ ba.

Các tính năng chính của Ollama cho PC

Quyền riêng tư và truy cập ngoại tuyến

Ollama cho phép chạy LLM trực tiếp trên máy mà không cần internet, đảm bảo dữ liệu cá nhân và doanh nghiệp không rời khỏi thiết bị. Đây là lợi thế lớn so với các dịch vụ đám mây.

Quản lý mô hình dễ dàng

Người dùng có thể tải và triển khai mô hình chỉ với một lệnh (ollama pull). Hiện có hơn 150 mô hình hỗ trợ, từ DeepSeek R1, Smollm đến các mô hình phổ biến như Gemma 2, Phi 4, Codestral.

Cài đặt nhanh chóng

Ollama được tối ưu để cài đặt trên Windows, Linux và macOS. Chỉ với một lệnh, CLI của Ollama sẽ sẵn sàng trên máy tính mà không cần thiết lập phức tạp.

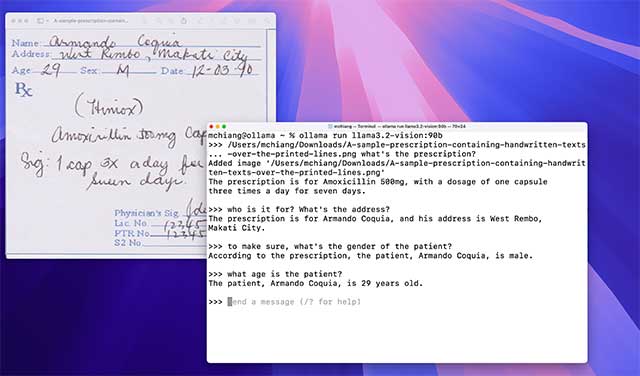

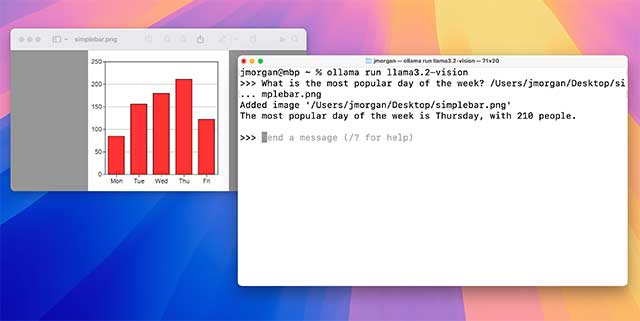

API cục bộ mạnh mẽ

Thông qua lệnh ollama serve, người dùng có thể triển khai API để tích hợp LLM vào ứng dụng khác, gửi prompt và nhận phản hồi có cấu trúc, phục vụ nhiều tác vụ AI khác nhau.

Tùy chỉnh linh hoạt

Với Ollama, người dùng có thể tinh chỉnh các tham số và trích xuất giá trị tối đa từ LLM trên máy cục bộ. Bạn cũng có thể thay đổi cấu hình để tinh chỉnh các tham số LLM, điều chỉnh cài đặt và thay đổi hành vi của mô hình để phù hợp hơn với nhu cầu của mình.

Tận dụng phần cứng

Hệ thống của Ollama sẽ tự động nhận diện và tận dụng GPU/CPU để tối ưu hiệu suất, cho phép chạy các LLM dung lượng lớn trên máy cá nhân.

Giao diện người dùng trực quan

Ngoài CLI, Ollama còn có Web UI mã nguồn mở với giao diện trò chuyện thân thiện, hoạt động hoàn toàn ngoại tuyến, dễ sử dụng cho cả người mới.

Nhìn chung, Ollama là lựa chọn phù hợp cho các nhà phát triển, lập trình viên và tổ chức muốn chạy LLM an toàn, bảo mật và linh hoạt ngay trên máy tính cá nhân. Với sự kết hợp giữa cài đặt nhanh, kho mô hình phong phú và khả năng chạy ngoại tuyến, Ollama hứa hẹn trở thành công cụ đáng tin cậy trong xu hướng AI on-device hiện nay.